Andrej Karpathy微软Build大会

2025年6月14日

16:00

Why RLHF?

It is easier to discriminate than to generate.让外包去做排序任务,而不是让外包人员生成样本。

但是,在某些情况下,RLHF并不优于base模型,RLHF模型失去了一些熵,即他们会输出分布更尖锐的结果,即很自信地输出,它们输出的样本比基础模型的变化要小。基础模型的输出更加多样化。

Base model can be better at tasks where you have N examples and want to generate more things.

Human text generation vs LLM text generation

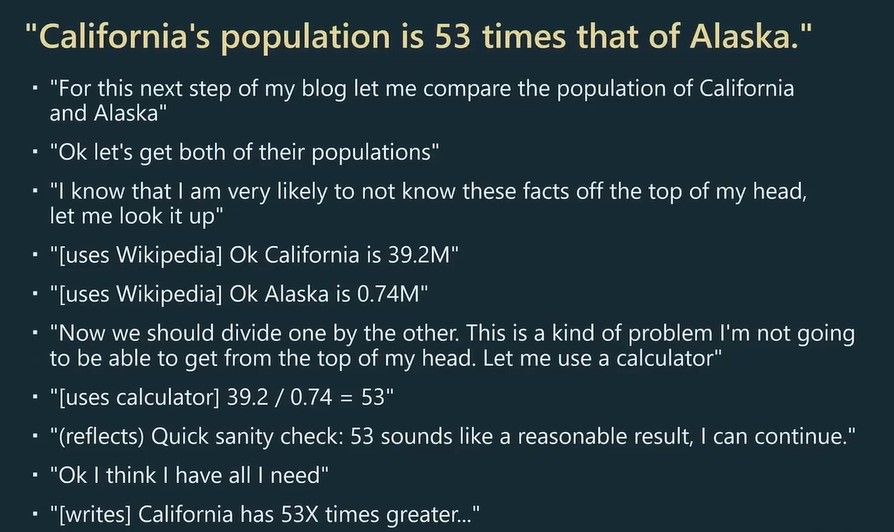

假设要以Califormia's population is 53 times that of alaska为主题写文章,对于人类来说,脑海里可能如下构思:

在构思的过程中,人类脑海里知道自己知道什么,不知道什么,有自我认知,会使用一些工具来查阅资料,可能会在脑海里进行一些反思和合理性检查。简言之,当人创造这样的句子时,人的内心独白实际上发生了很多事情。

对于GPT来说,当GPT在训练或生成这些token时,GPT只是在逐个处理token,然后尽力地模仿出这段话,这跟人类的创造是很不一样的,In particular, in the dataset that we create, then feed in llm, all the internal dialogue was completely stripped , and unlike you , GPT will look at every single token and spend the same amount of computes on every token. LLM不知道人在创造这些句子时,发生的哪些内心独白,LLM只看到了最后的结果,对于LLM来说,每个token都是同样重要的。LLM可以看成是 token生成器, 它们不知道自己擅长什么,不擅长什么,它们只是尽力模仿下一个token,它们不进行反思,也不会进行合理性检查,也不会在生成过程中纠正自己的错误,它们没有像人类一样的内心独白流。鹦鹉学舌。

虽然如此,LLM确立有认知优势,LLM拥有非常广泛的事实基础知识 ,涵盖了大量领域。

Prompt只是弥补了人类大脑和LLM这两种认知架构的差异。

如果你的任务需要推理,you can't expect the transformer to do too much reasoning per token, you have to spread out the reasoning across more tokens. 例如,你不能给LLM一个非常复杂的问题,并期望它只输出单个token作为答案,它没有足够的时间,LLM needs tokens to think. 即few-shot prompt,或 let's think step by step这种方式。

Ensemble multiple attempts

LLM can get "unlucky " and sample a bad thought, once they do ,the are 'stuck with it'。 Make a few attempts

LLM输出采样的时候,可能会采样到差的token,可以多让LLM进行几次回答,然后vote一下。

Condition on good performance

LLM just want to imitate training sets which has a wide spectrum of data qualities, you should ask llm to imitate high quality data to succeed.

例如,对于某个物理问题,LLM的训练数据集里可能有包含有某个学生的错误答案,也包含某个教授的正确答案,但是LLM对于这两个答案是一视同仁的,所以需要在prompt中显式地指明“我们要得到正确答案的”condition限制,例如“lets think step by step to get the correct answer,” “你是这个领域的专家…”,“假设你的智商是120”

Finetune

Lora的一个优点:由于不需要对原始的模型进行反向传播(原始模型的参数被冻结了),所以可以对原始的大模型进行量化,进行低精度的推理计算。

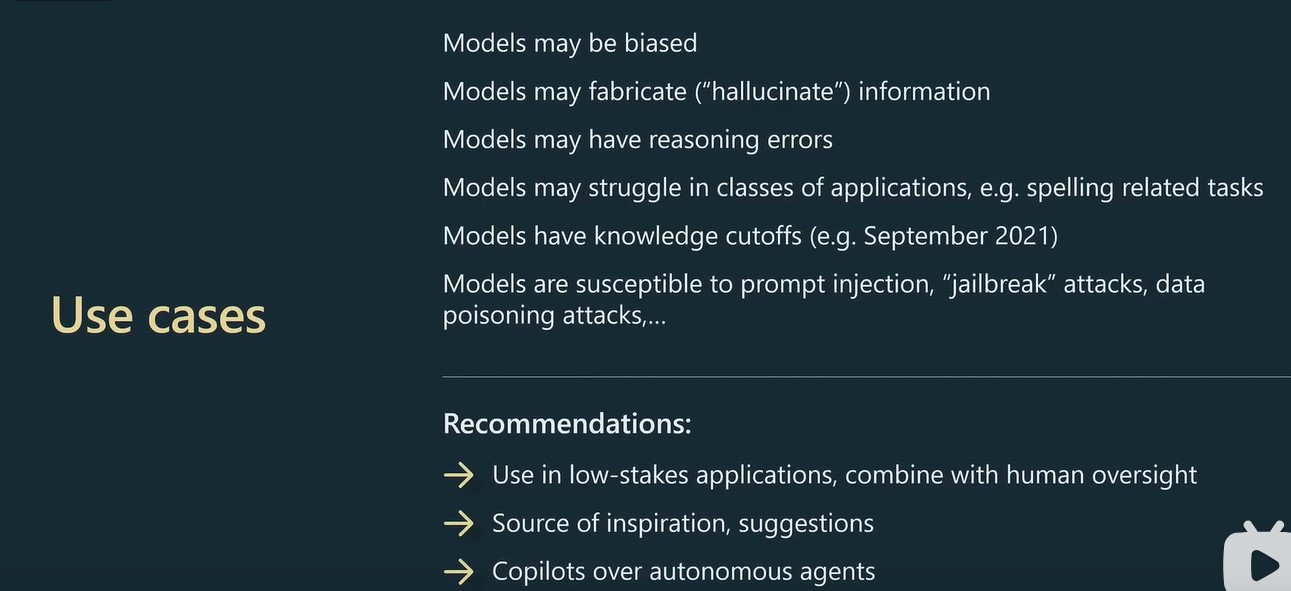

Use cases