SVM

2025年9月25日

10:31

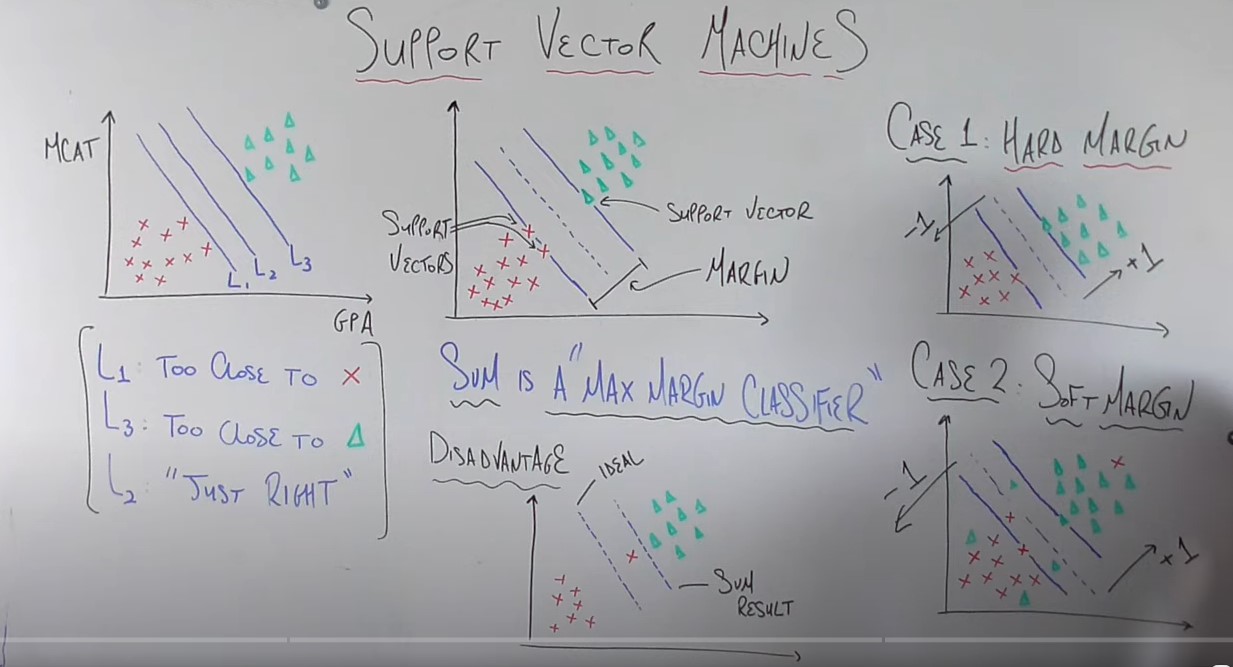

SVM:max margin classifier,分为硬间隔和软间隔,软间隔允许分错,但是每分错一个样本,需要进行惩罚。

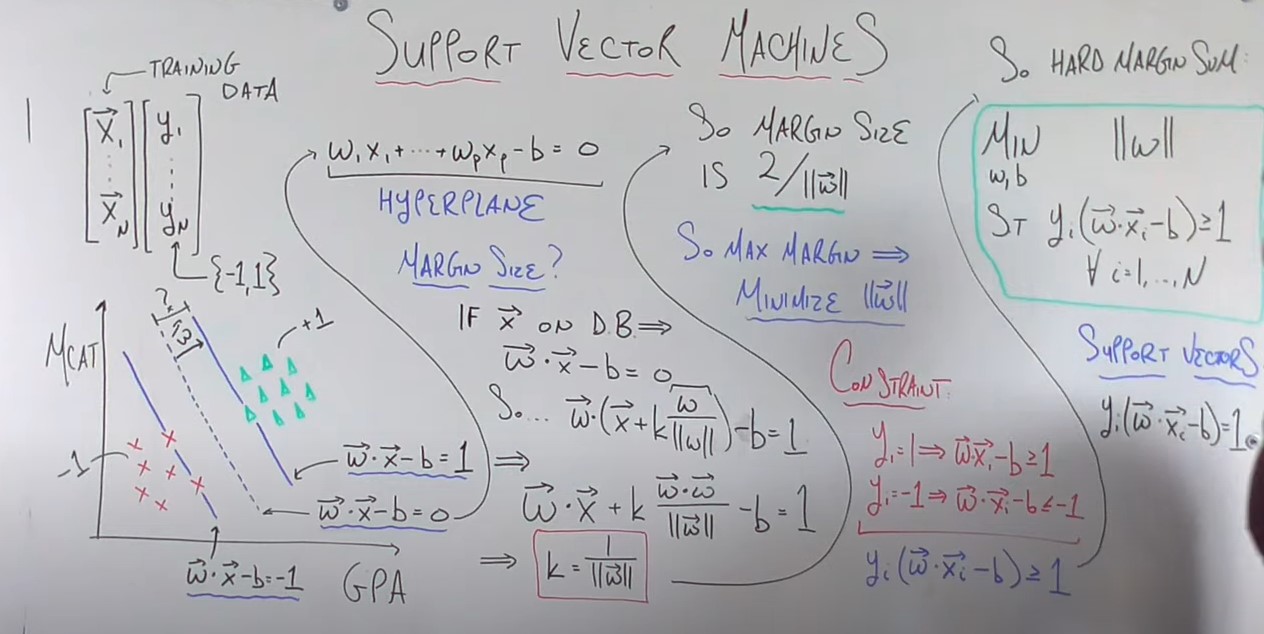

SVM对二分类的类别进行了约定,+1和-1。这样约定后,在数学上,decision boundary就是wx+b=0,+1类别的支持向量是落在wx+b=1这个超平面的所有样本,-1类别的支持向量是落在wx+b=-1这个超平面的所有样本,并且margin =1/||w||。

max margin <==>minimize ||w||,但是需要满足约束条件:y_i(w*x_i+b)>=1,(这个约束条件保证超平面能正确分类样本),也就是说,硬SVM的Loss是||w||。

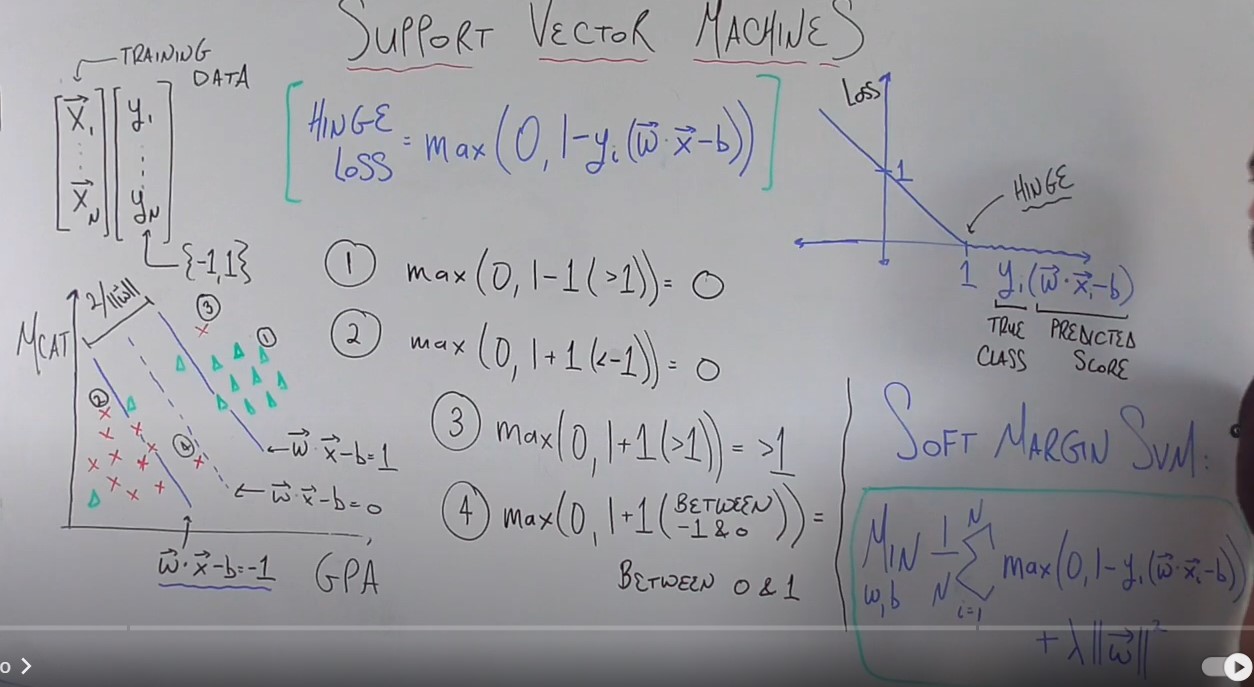

软间隔SVM的loss是hinge loss,

- 如果样本被正确分类且到决策边界decision boundary的距离大于支持向量到decision boundary的距离 ,loss是0

- 如果样本被错误分类,那么loss大于1

- 如果样本被正确分类,但是样本到决策边界的距离小于支持向量到决策边界的距离,虽然被正确分类,也会有loss,此时loss小于1

除了hinge loss,软svm还引入 了硬svm的loss,||w||^2,并通过超参数lambda控制二者的平衡。